最近DeepSeek的需求量太高了,昨天给大家分享了一篇 Chatbox AI接入Deepseek API并实现联网搜索保姆级教程 的教程,结果有小伙伴问,如果想要在网页端或者分享给朋友也一起使用的话,应该如何操作呢?

今天就给大家分享这个使用LobeChat接入Deepseek API,实现在任何设备,通过浏览器就可以访问使用AI了。本教程涉及到服务器部署,所以首先你得有一台云服务器,1核1G以上就可以。

一、API接口获取

API密钥获取有多个渠道,推荐几个常用的渠道,可以都作为备选项去使用(DeepSeek-R1的算力要求极高,且最近热度很高,几乎所有API厂商的接口都算不上稳定,用不了就切换下一个接口就好)。

- 腾讯云:进入腾讯云官网,注册并登录账号,然后进入“知识引擎原子能力”控制台,使用OpenAI SDK方式接入创建密钥(这是通用OpenAI格式)。

- 硅基流动:进入硅基流动官网注册并登录账号,点击左侧菜单的“API 密钥”,然后新建API密钥。

- MKEAI API中转站:进入MKEAI API中转站注册并登录账号,点击左侧菜单的“我的令牌”,添加令牌。

- 其他的就不一一列出来了,只要API厂商介绍的支持openai通用格式的,都能使用。

二、云服务器购买推荐

- 腾讯云:腾讯云爆款专区提供了99元/年的大陆云服务器,性价比极高。

- 蓝米云:蓝米云新用户6折优惠,专注海外云服务器,香港轻量云90元/年(无需备案)。

三、安装宝塔面板

之前有给大家分享过服务器安装宝塔面板的新手教程,有不懂的小伙伴可以看一下教程。

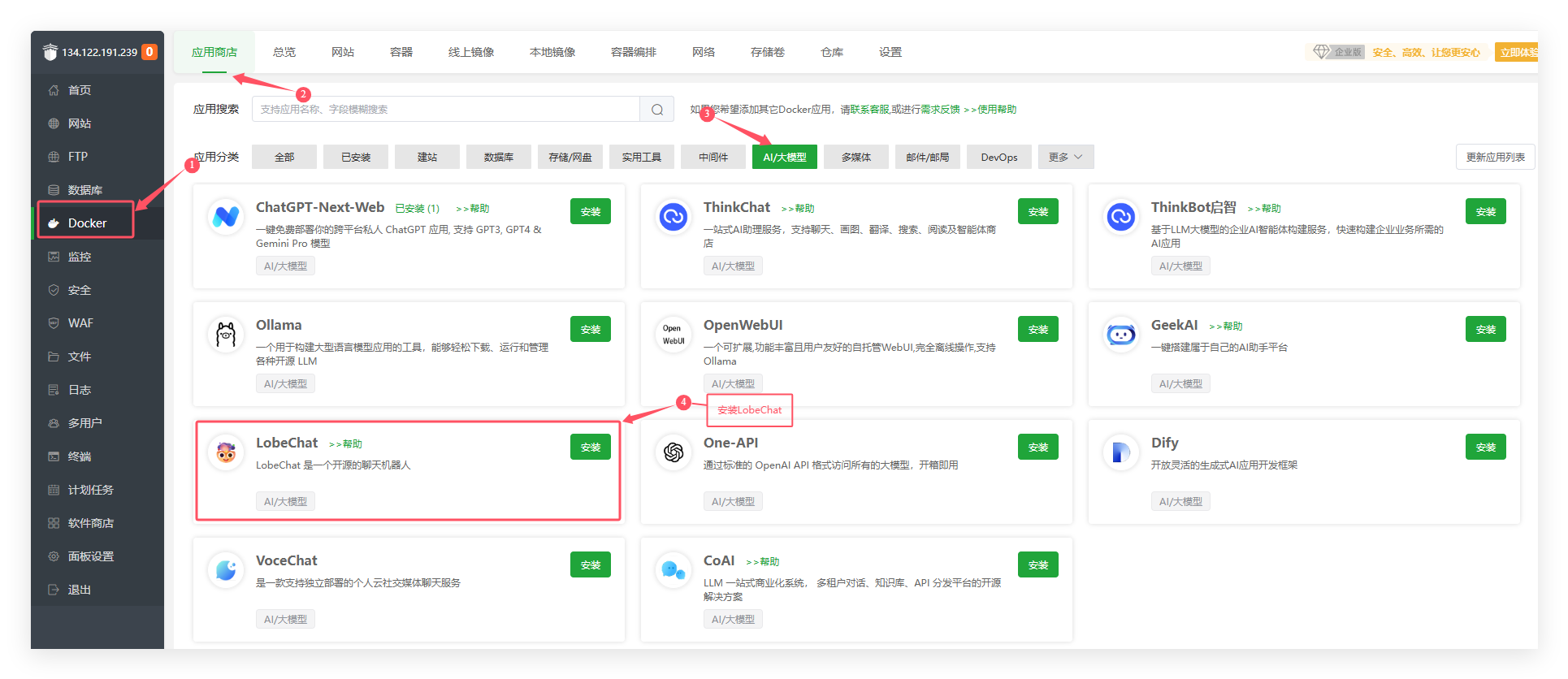

四、安装LobeChat

点击Docker中的应用商店,应用分类选择AI/大模型,在里面可以看到有个LobeChat,点击安装即可(如果你是第一次打开Docker界面,会出现提示让你安装Docker,根据提示先安装后就可以操作了)。

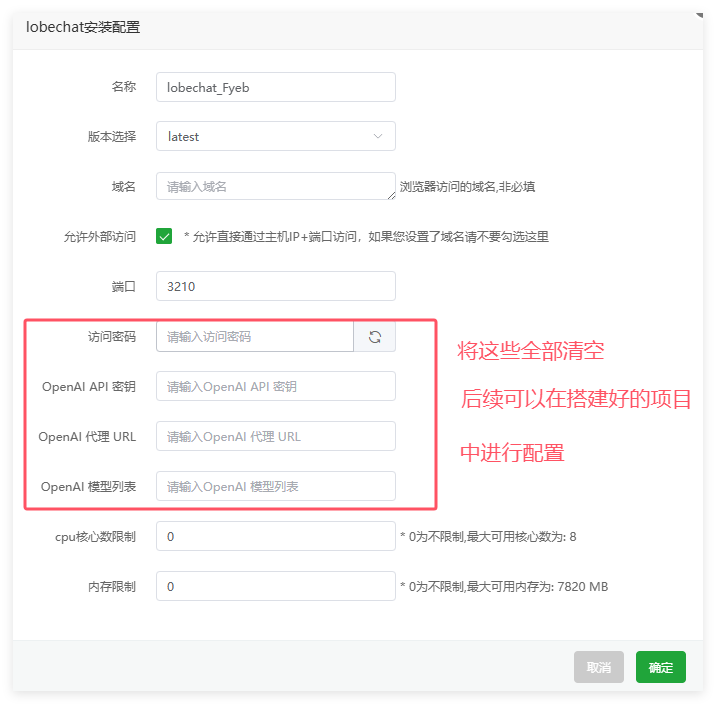

在弹出的安装配置窗口中,可以将访问密码、API密钥、代理URL、模型列表都去掉,其他保持默认,后续可以在LobeChat中直接配置,更方便一些。

点击确定后,就耐心等待项目安装完成。

安装完成后,直接访问http://你的服务器ip:3210,例如:http://127.0.0.1:3210 即可进入刚刚搭建好的LobeChat聊天面板。

五、配置LobeChat

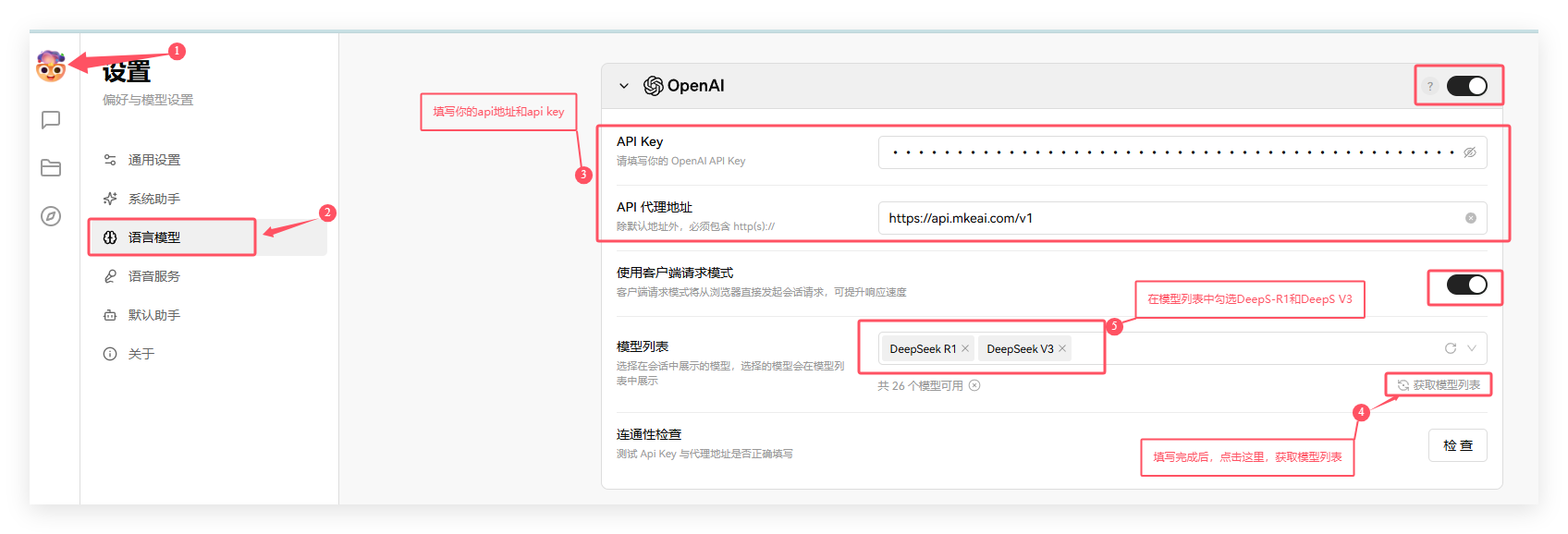

首先需要需要进行模型配置,点击头像->应用设置,然后点击语言模型,LobeChat支持多个API厂商和模型,自行选择下面任意一种方式接入就可以了。

- OpenAI通用格式配置方式:

1、如果你的API是OpenAI通用格式,例如:MKEAI API中转,就可以按照如下方式进行配置。

2、重点就是API KEY和API代理地址,API KEY填写你创建的令牌,API代理地址填写你的API厂商提供的地址。

3、填写完API KEY和API代理地址后,可以点击获取模型列表,获取完成后,模型列表就会显示这个API厂商支持哪些模型,我这里就选择了DeepSeek-R1和DeepSeek V3模型。

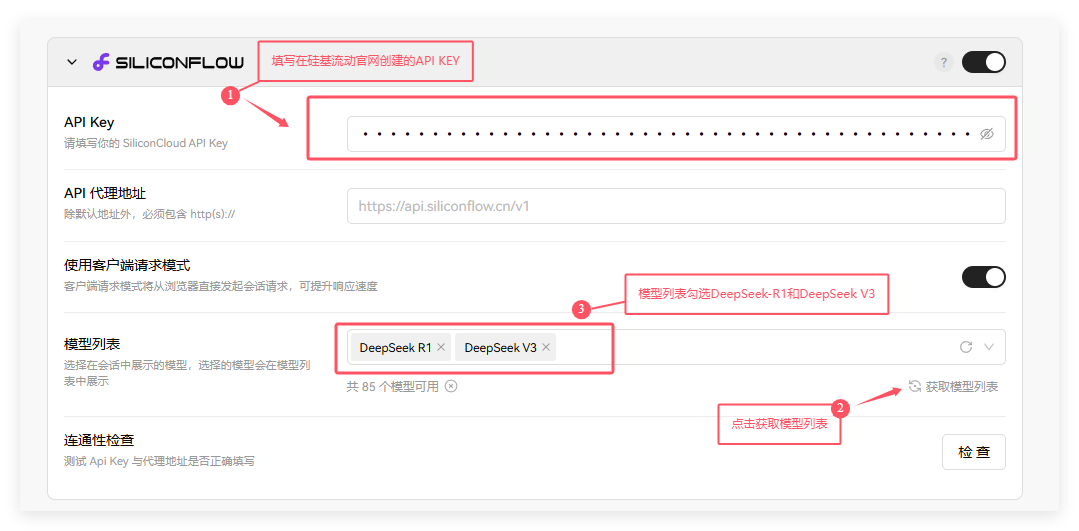

- 硅基流动API配置方式:

在厂商列表中找到siliconflow,先点击右侧的开启按钮,然后按图片上的方式进行配置即可。

硅基流动不需要设置API代理地址,只需要填写API KEY,然后获取模型列表,勾选想要使用的模型即可。

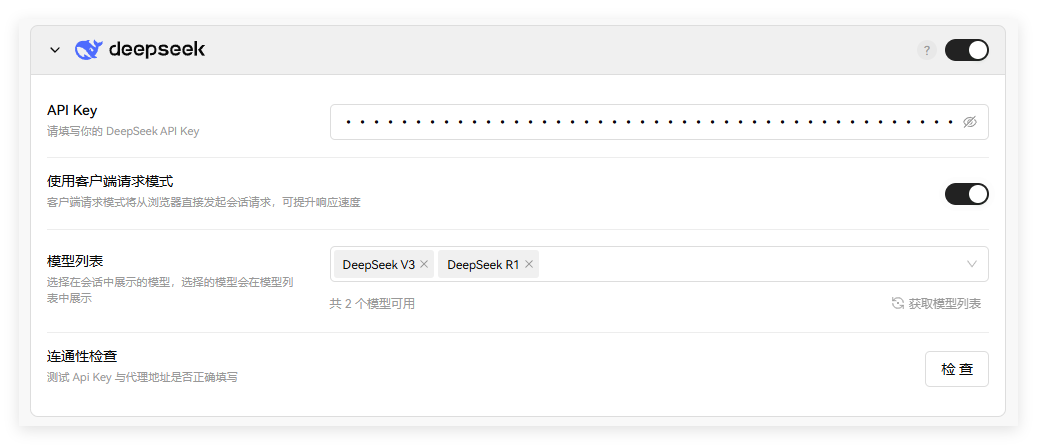

- DeepSeek官方API配置方式:

配置方式和硅基流动一样,在厂商列表中找到DeepSeek,点击右侧的开启选项,然后输入在DeepSeek官网创建的API KEY,填写进来就行了。

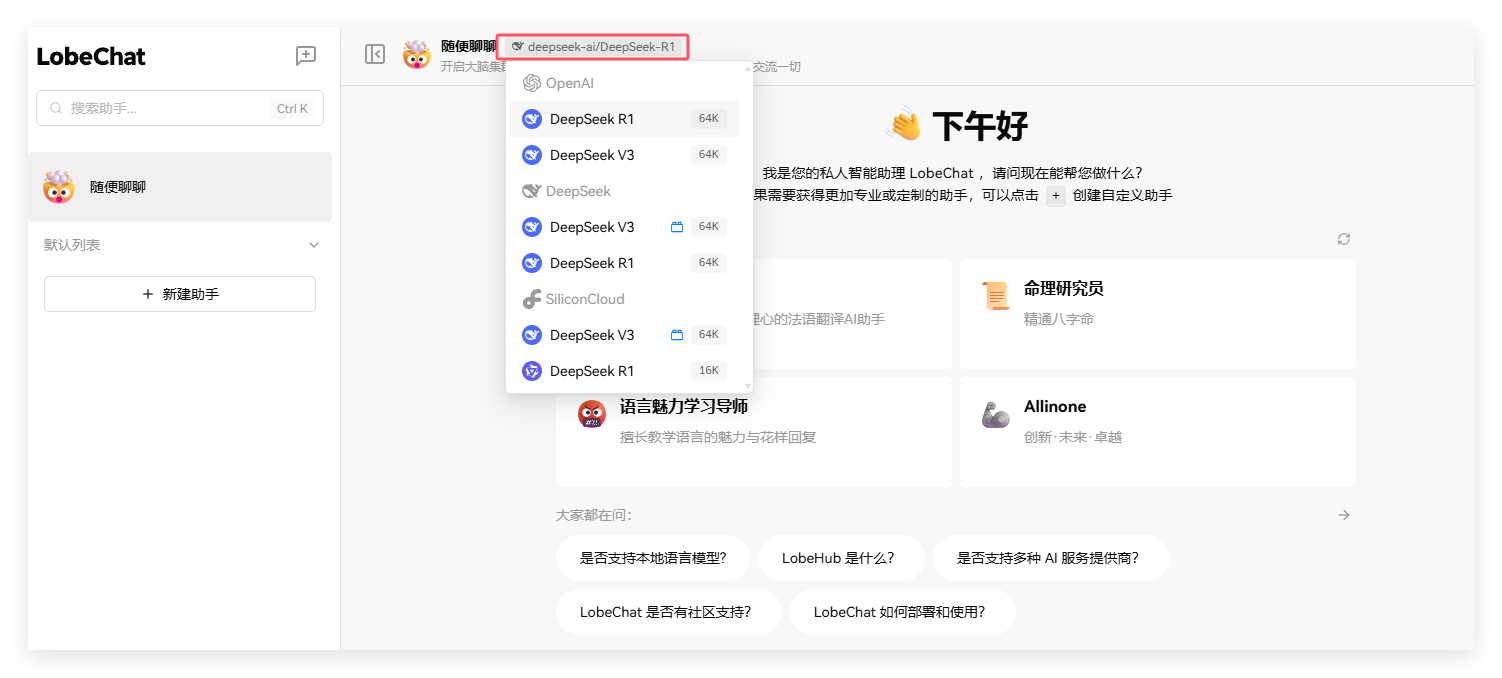

好了,最后我们回到LobeChat的聊天界面,测试一下是否能正常使用。

点击聊天界面的顶部模型名称,可以切换不同厂商和对应的模型。

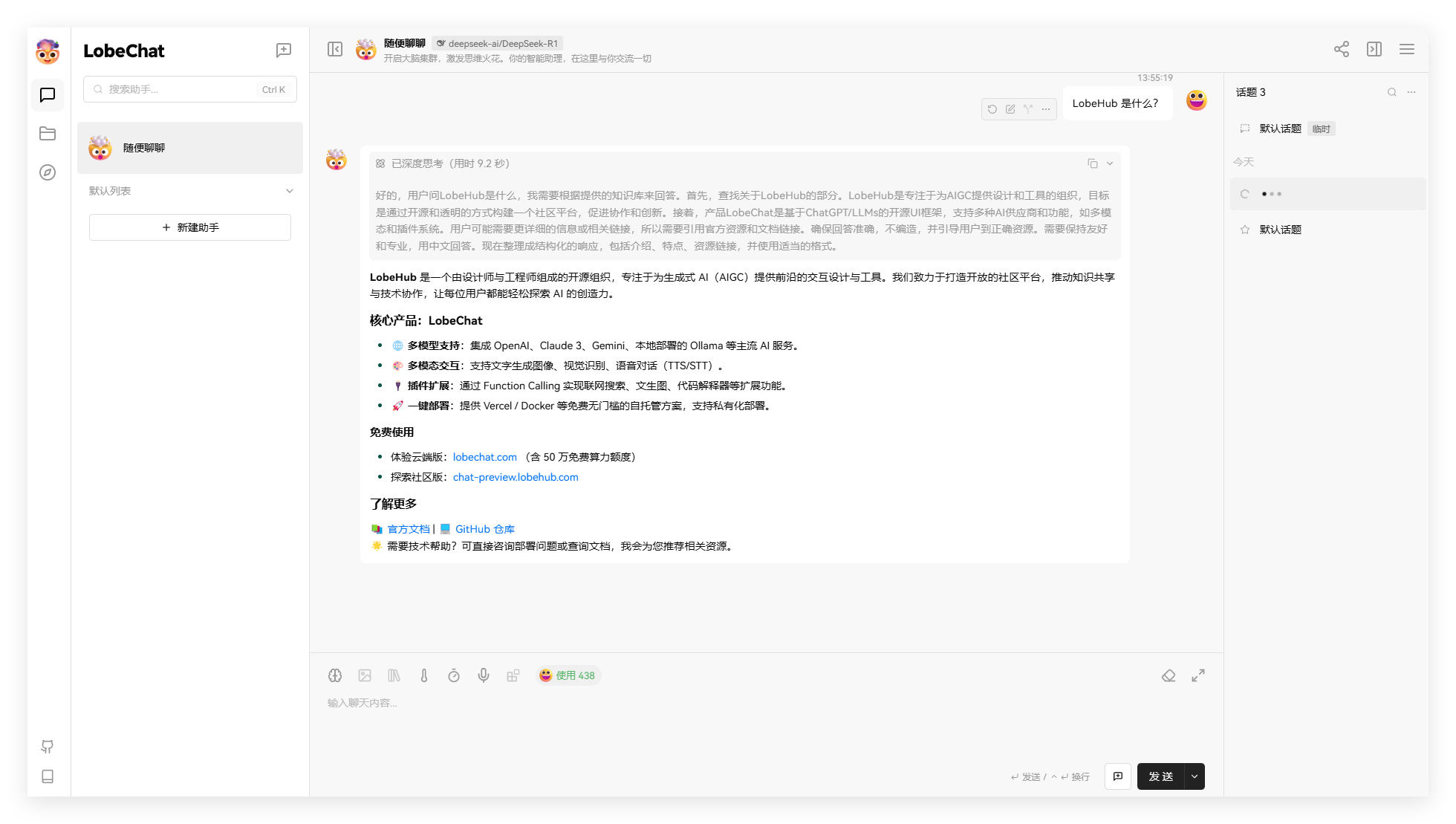

勾选完模型后,直接可以发起聊天了。

LobeChat的界面非常美观,而且对DeepSeek-R1的深度思考显示很友好,看起来就特别舒服,唯一的缺点就是页面加载有点慢,而且暂时不支持DeepSeek模型的联网搜索(需要联网搜索可以看本站其他教程)。

好了,今天的教程就到这里,感兴趣的小伙伴,一定注意收藏本站,持续分享更多更好玩的原创AI技术教程。